Servers in stock

Checking availability...

-

Gracias a su rendimiento de baja latencia, las TPU son muy adecuadas para aplicaciones en tiempo real como motores de recomendación y detección de fraude.

Las TPU están diseñadas para entrenar de manera eficiente modelos complejos como GPT-4 y BERT, reduciendo significativamente tanto el tiempo de entrenamiento como los costos computacionales.

Desde modelos climáticos hasta simulaciones de proteínas, las TPU proporcionan a los investigadores la velocidad y la potencia necesarias para realizar descubrimientos revolucionarios.

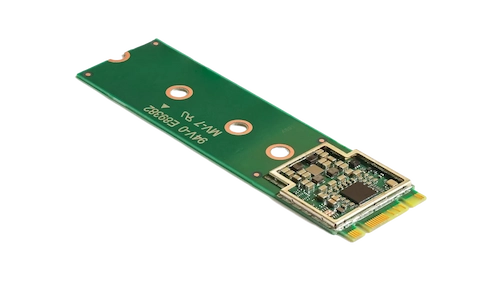

El acelerador Coral M.2 optimiza el aprendizaje automático en el dispositivo al proporcionar inferencias rápidas con un consumo mínimo de energía. Su integración en el sistema permite un procesamiento de aprendizaje automático eficiente y en tiempo real en el borde, reduciendo tanto la latencia como la dependencia de los recursos de la nube.

El procesador de IA perimetral Hailo-8 ofrece hasta 26 TOPS en un formato ultracompacto, más pequeño que una moneda de un centavo, memoria incluida. Su arquitectura optimizada para redes neuronales permite el aprendizaje profundo en tiempo real en dispositivos perimetrales con un bajo consumo de energía, lo que lo hace ideal para aplicaciones en la industria automotriz, ciudades inteligentes y automatización industrial. Este diseño eficiente permite una IA de alto rendimiento en el perímetro, minimizando el consumo de energía y los costos generales.

Diseñadas para sobresalir en tareas con gran cantidad de matrices, las TPU proporcionan velocidades de entrenamiento e inferencia aceleradas en comparación con las GPU tradicionales.

Permite distribuir el entrenamiento entre múltiples unidades, lo que posibilita una escalabilidad eficiente para modelos a gran escala.

Ofrece soporte para marcos de aprendizaje automático populares como TensorFlow, PyTorch (a través de OpenXLA) y JAX, lo que garantiza una integración sin esfuerzo con sus procesos existentes.

Integradas con Google Kubernetes Engine (GKE) y Vertex AI, las TPU proporcionan una fácil orquestación y gestión de cargas de trabajo de IA.