Servers in stock

Checking availability...

-

Dank ihrer geringen Latenz eignen sich TPUs hervorragend für Echtzeitanwendungen wie Empfehlungssysteme und Betrugserkennung.

TPUs sind so konzipiert, dass sie komplexe Modelle wie GPT-4 und BERT effizient trainieren und dadurch sowohl die Trainingszeit als auch die Rechenkosten deutlich senken.

Von Klimamodellen bis hin zu Proteinsimulationen – TPUs geben Forschern die Geschwindigkeit und Leistung, die für bahnbrechende Entdeckungen erforderlich sind.

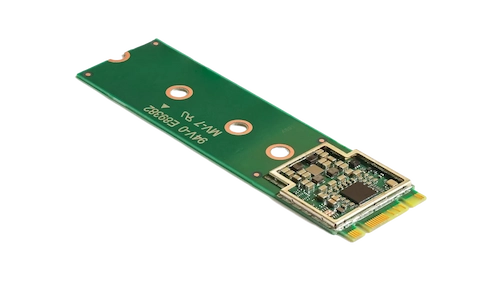

Der Coral M.2 Accelerator beschleunigt maschinelles Lernen direkt auf dem Gerät durch schnelle Inferenz bei minimalem Stromverbrauch. Durch die Integration in Ihr System ermöglichen Sie effiziente Echtzeit-ML-Verarbeitung am Netzwerkrand und reduzieren so Latenz und Abhängigkeit von Cloud-Ressourcen.

Der Hailo-8 Edge-KI-Prozessor liefert bis zu 26 TOPS in einem ultrakompakten Gehäuse – kleiner als eine 1-Cent-Münze, inklusive Speicher. Seine für neuronale Netze optimierte Architektur ermöglicht Deep Learning in Echtzeit auf Edge-Geräten bei geringem Stromverbrauch und ist damit ideal für Anwendungen in der Automobilindustrie, Smart Cities und der industriellen Automatisierung. Dieses effiziente Design unterstützt leistungsstarke KI am Edge und minimiert gleichzeitig Energieverbrauch und Gesamtkosten.

TPUs wurden für Aufgaben mit hohem Matrixanteil entwickelt und bieten im Vergleich zu herkömmlichen GPUs beschleunigte Trainings- und Inferenzgeschwindigkeiten.

Ermöglicht die Verteilung des Trainings auf mehrere Einheiten und somit eine effiziente Skalierbarkeit für groß angelegte Modelle.

Bietet Unterstützung für gängige ML-Frameworks wie TensorFlow, PyTorch (über OpenXLA) und JAX und gewährleistet so eine mühelose Integration in Ihre bestehenden Prozesse.

Durch die Integration mit Google Kubernetes Engine (GKE) und Vertex AI ermöglichen TPUs eine einfache Orchestrierung und Verwaltung von KI-Workloads.