Servers in stock

Checking availability...

Graças ao seu desempenho de baixa latência, as TPUs são ideais para aplicações em tempo real, como sistemas de recomendação e detecção de fraudes.

As TPUs são projetadas para treinar com eficiência modelos complexos como GPT-4 e BERT, reduzindo significativamente o tempo de treinamento e os custos computacionais.

Desde modelos climáticos até simulações de proteínas, as TPUs (Unidades de Processamento de Tecnologia) oferecem aos pesquisadores a velocidade e a potência necessárias para descobertas inovadoras.

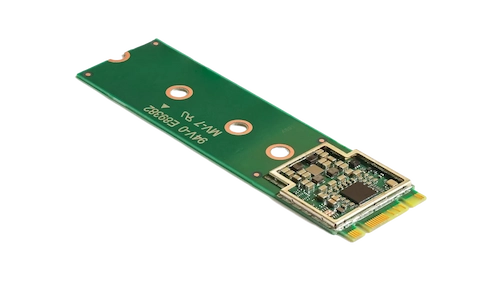

O acelerador Coral M.2 potencializa o aprendizado de máquina no dispositivo, oferecendo inferência rápida com consumo mínimo de energia. Sua integração ao sistema permite o processamento eficiente de aprendizado de máquina em tempo real na borda, reduzindo a latência e a dependência de recursos em nuvem.

O processador de IA de borda Hailo-8 oferece até 26 TOPS em um pacote ultracompacto — menor que uma moeda de um centavo, incluindo a memória. Sua arquitetura otimizada para redes neurais permite aprendizado profundo em tempo real em dispositivos de borda com baixo consumo de energia, tornando-o ideal para aplicações automotivas, cidades inteligentes e automação industrial. Esse design eficiente suporta IA de alto desempenho na borda, minimizando o consumo de energia e os custos gerais.

Projetadas para se destacarem em tarefas que envolvem muitas matrizes, as TPUs oferecem velocidades aceleradas de treinamento e inferência em comparação com as GPUs tradicionais.

Permite que o treinamento seja distribuído por várias unidades, possibilitando uma escalabilidade eficiente para modelos de grande escala.

Oferece suporte para frameworks populares de aprendizado de máquina, como TensorFlow, PyTorch (via OpenXLA) e JAX, garantindo uma integração fácil com seus processos existentes.

Integradas ao Google Kubernetes Engine (GKE) e ao Vertex AI, as TPUs proporcionam fácil orquestração e gerenciamento de cargas de trabalho de IA.