Servers in stock

Checking availability...

-

Grâce à leurs performances à faible latence, les TPU sont parfaitement adaptés aux applications en temps réel telles que les moteurs de recommandation et la détection des fraudes.

Les TPU sont conçus pour entraîner efficacement des modèles complexes tels que GPT-4 et BERT, réduisant considérablement le temps d'entraînement et les coûts de calcul.

Des modèles climatiques aux simulations de protéines, les TPU offrent aux chercheurs la rapidité et la puissance nécessaires à des découvertes révolutionnaires.

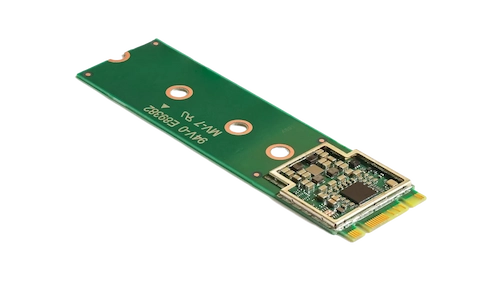

L'accélérateur Coral M.2 optimise l'apprentissage automatique embarqué en assurant une inférence rapide et une consommation d'énergie minimale. Son intégration à votre système permet un traitement ML efficace et en temps réel en périphérie, réduisant ainsi la latence et la dépendance aux ressources cloud.

Le processeur d'IA embarqué Hailo-8 offre jusqu'à 26 TOPS dans un format ultra-compact, plus petit qu'une pièce de monnaie (mémoire incluse). Son architecture optimisée pour les réseaux neuronaux permet un apprentissage profond en temps réel sur les appareils périphériques, tout en consommant peu d'énergie. Il est donc idéal pour les applications automobiles, les villes intelligentes et l'automatisation industrielle. Cette conception efficace prend en charge l'IA haute performance en périphérie tout en minimisant la consommation d'énergie et les coûts globaux.

Conçues pour exceller dans les tâches nécessitant un traitement matriciel intensif, les TPU offrent des vitesses d'entraînement et d'inférence accélérées par rapport aux GPU traditionnels.

Permet de répartir la formation sur plusieurs unités, assurant ainsi une mise à l'échelle efficace pour les modèles à grande échelle.

Il offre une prise en charge des frameworks ML populaires tels que TensorFlow, PyTorch (via OpenXLA) et JAX, garantissant une intégration sans effort avec vos processus existants.

Intégrés à Google Kubernetes Engine (GKE) et à Vertex AI, les TPU facilitent l'orchestration et la gestion des charges de travail d'IA.