Servers in stock

Checking availability...

-

Grazie alle loro prestazioni a bassa latenza, le TPU sono adatte ad applicazioni in tempo reale come motori di raccomandazione e rilevamento delle frodi.

Le TPU sono progettate per addestrare in modo efficiente modelli complessi come GPT-4 e BERT, riducendo significativamente sia i tempi di addestramento sia i costi computazionali.

Dai modelli climatici alle simulazioni proteiche, le TPU forniscono ai ricercatori la velocità e la potenza necessarie per scoperte rivoluzionarie.

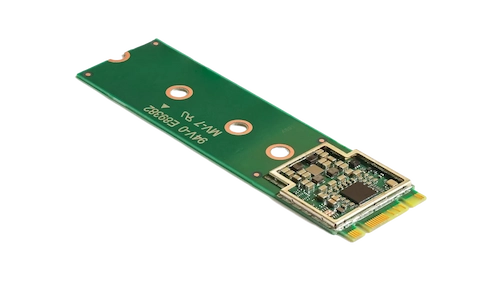

Coral M.2 Accelerator potenzia l'apprendimento automatico on-device offrendo inferenze rapide con un consumo energetico minimo. Integrandolo nel tuo sistema, consente un'elaborazione ML efficiente e in tempo reale a livello edge, riducendo sia la latenza che la dipendenza dalle risorse cloud.

Il processore AI edge Hailo-8 offre fino a 26 TOPS in un formato ultracompatto, più piccolo di un centesimo, memoria inclusa. La sua architettura ottimizzata per reti neurali consente il deep learning in tempo reale su dispositivi edge con un basso consumo energetico, rendendolo ideale per applicazioni nei settori automotive, smart city e automazione industriale. Questo design efficiente supporta l'intelligenza artificiale ad alte prestazioni a livello edge, riducendo al minimo il consumo energetico e i costi complessivi.

Progettate per eccellere in attività che richiedono l'uso intensivo di matrici, le TPU garantiscono velocità di addestramento e inferenza accelerate rispetto alle GPU tradizionali.

Consente di distribuire la formazione su più unità, consentendo una scalabilità efficiente per modelli su larga scala.

Offre supporto per framework ML diffusi come TensorFlow, PyTorch (tramite OpenXLA) e JAX, garantendo un'integrazione senza sforzo con i processi esistenti.

Integrate con Google Kubernetes Engine (GKE) e Vertex AI, le TPU semplificano l'orchestrazione e la gestione dei carichi di lavoro di intelligenza artificiale.