Servers in stock

Checking availability...

-

Datorită performanței lor cu latență redusă, TPU-urile sunt potrivite pentru aplicații în timp real, cum ar fi motoarele de recomandări și detectarea fraudelor.

TPU-urile sunt proiectate pentru a antrena eficient modele complexe precum GPT-4 și BERT, reducând semnificativ atât timpul de antrenament, cât și costurile de calcul.

De la modele climatice la simulări de proteine, TPU-urile oferă cercetătorilor viteza și puterea necesare pentru descoperiri revoluționare.

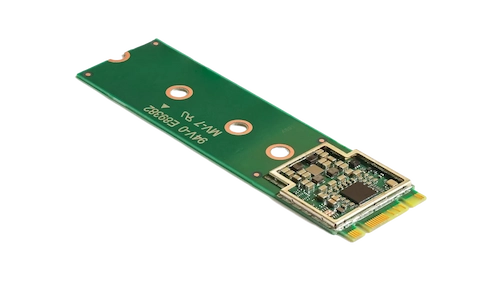

Acceleratorul Coral M.2 stimulează învățarea automată pe dispozitiv, oferind inferențe rapide cu un consum minim de energie. Integrarea sa în sistemul dvs. permite procesarea eficientă, în timp real, a învățării automate la periferie, reducând atât latența, cât și dependența de resursele cloud.

Procesorul Hailo-8 edge AI oferă până la 26 TOPS într-un pachet ultracompact - mai mic decât un ban, inclusiv memoria. Arhitectura sa optimizată pentru rețele neuronale permite învățarea profundă în timp real pe dispozitive edge cu consum redus de energie, fiind ideal pentru aplicații auto, orașe inteligente și automatizare industrială. Acest design eficient susține inteligența artificială de înaltă performanță la edge, reducând în același timp consumul de energie și costurile generale.

Construite pentru a excela în sarcini care utilizează matrice, TPU-urile oferă viteze de antrenament și inferență accelerate în comparație cu GPU-urile tradiționale.

Permite distribuirea antrenamentului pe mai multe unități, asigurând scalabilitate eficientă pentru modele la scară largă.

Oferă suport pentru framework-uri ML populare, cum ar fi TensorFlow, PyTorch (prin OpenXLA) și JAX, asigurând o integrare fără efort cu procesele existente.

Integrate cu Google Kubernetes Engine (GKE) și Vertex AI, TPU-urile oferă o orchestrare și o gestionare ușoară a sarcinilor de lucru bazate pe inteligență artificială.